★ 北方工業大學電氣與控制工程學院張尊棟,劉雨珂,劉小明

摘要:交通擁堵已經成為全世界范圍內普遍存在的現象和亟待解決的難題,智能交通信號控制技術是緩解交通擁堵的重要手段。傳統基于模型的自適應交通信號控制系統靈活性較低,往往依賴于大量的假設和經驗方程,難以滿足當前復雜多變交通系統的控制要求。隨著計算機技術的進步、數據處理技術的發展和人工智能算法的成熟,結合深度強化學習方法的交通信號控制逐漸成為最主要的研究熱點。

1 引言

城市交通控制系統用于避免、減緩交通擁堵,在交叉口控制和主干路控制方面取得了很好的效果。隨著城市規模的擴大和車輛保有量的增加,科研人員和工程師發現已有的控制方法難以實現整體的控制效果,交通擁堵問題日益突出[1]。

隨著人工智能技術的進步,交通系統正逐步朝著智能化方向發展。傳統的自適應交通信號控制通過現有經驗構建模型或簡化的交通模型求解最優的信號控制策略,往往依賴于大量的假設和經驗方程,難以滿足當前復雜多變交通系統控制的要求。Mikam等人[2]首次將強化學習用于交通信號控制。但強化學習方法在面對狀態復雜、連續化問題時存在“維度爆炸”,而難以進行自主決策。伴隨著強化學習和深度學習技術的發展,有學者提出將兩者結合在一起形成深度強化學習方法(Deep Reinforcement Learning,DRL)[3]。Li等人[4]采用深度強化學習技術對單交叉口控制問題進行了研究,并作出了改進。由于強化學習及深度強化學習應用在普通簡單路口的控制中往往能夠取得較好效果,因此多交叉口交通信號控制越來越成為人們的研究熱點。

本文將簡述深度強化學習基礎理論并根據動作選擇方式對其分類,進而介紹深度強化學習方法在單交叉口、多交叉口交通信號控制領域的應用,最后討論交通信號控制未來的研究方向和挑戰。希望本篇綜述能為研究深度強化學習在交通中的應用提供參考。

2 深度強化學習

深度學習強大的特征提取能力,結合強化學習的自主決策能力形成深度強化學習,使強化學習不再受數據空間維度問題,得以應用于高維、復雜的控制系統。根據優化過程中動作選取方式的不同,深度強化學習可以分為基于值的深度強化學習方法和基于策略梯度的深度強化學習方法。

2.1 基于值的深度強化學習方法

基于價值的深度強化學習方法通過準確估計狀態-動作的價值函數,選取最大值所對應的動作,隱式獲得確定性策略。采用深度神經網絡對值函數或者動作值函數進行近似,將應用范圍拓展到高維度問題和連續空間問題。Watkins等人[5]提出的Q學習算法通過對Q值函數的估計,在當前狀態下執行動作后轉換到下一狀態,智能體獲取環境獎勵并更新Q值函數。在有限的狀態動作空間下,Q學習算法可以收斂到最優Q值函數。Mnih等人[6]首次提出將深度神經網絡與Q學習結合的DQN算法,利用卷積神經網絡近似Q值,隨后又提出利用目標網絡和經驗回放穩定DQN的學習過程[3]。

然而,DQN每一次更新時都會采取最大化目標網絡,導致對動作價值函數過估計問題。Hasselt等人[7]采取雙網絡結構,當前網絡選取最優動作,目標網絡對所選動作進行評估,將動作選擇與策略評價分離,降低發生過估計的可能性。Wang等人[8]提出對抗架構DQN算法,直接估算狀態值函數和動作優勢函數,保證當前狀態下各動作的優勢函數相對排序不變,縮小Q值的范圍同時去除多余的自由度,提高算法的穩定性。Nair等人[9]提出了一個對于深度強化學習的大規模分布式架構,充分利用計算資源。此類算法只能處理有限的狀態動作空間問題,難以應對復雜環境,學習過程中易出現過擬合且收斂性較差,因此其適用于離散動作空間下的深度強化學習過程。

2.2 基于策略梯度的深度強化學習方法

策略梯度算法使策略參數化,將神經網絡的權重參數作為價值函數的參數,能通過分析所處的狀態,直接輸出下一步要采取的各種動作的概率,然后根據概率采取行動,每種動作都有相應的概率被選中。最經典的策略梯度算法REINFORCE[10]使用蒙特卡洛方法計算狀態值函數,近似替代策略梯度的價值函數。

由于蒙特卡洛策略梯度方法基于完整的經驗更新值函數參數,導致模型的學習效率較低。在線學習的置信域策略優化算法TPRO[11]與近端策略優化算法[12]根據經驗或自適應方法選擇超參數,使得更新步長約束在一定范圍內,確保持續獲得更優策略,防止策略崩潰問題。

TPRO與PPO算法在每次策略更新時采樣大量樣本進行訓練,需要大量算力確保算法收斂,導致其難以應用于大規模場景下的強化學習過程。Lillicrap[13]提出深度確定性策略梯度算法DDPG,該方法使用非線性函數近似表示值函數,使得函數能夠穩定收斂,解決了Q函數更新的發散問題。同時使用經驗回放機制批處理學習,從而使訓練過程更加穩定。Fujimoto等人[14]為解決DDPG對于Q值的高估,及超參數和其他參數調整方面存在脆弱性的問題,提出TD3算法,可緩解動作價值高估的影響,并消除方差累計問題,使得訓練過程波動較小,同時避免了DDPG中可能發生的特性故障。

與基于價值的深度強化學習方法相比,基于策略的強化學習方法具有更好的收斂性,特別在利用神經網絡逼近函數時[15],它可以很容易地處理大量甚至連續的狀態動作空間。但其缺點在于算法方差較高、收斂速度較慢及學習步長難以確定。

2.3 基于深度強化學習的交通信號控制模型設置

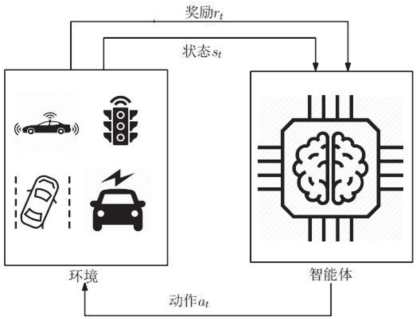

在基于深度強化學習的交通信號控制中,路網中的交通信號通常由一個智能體獨立控制或多個智能體控制,智能體表示交通信號燈。智能體執行某動作后,環境會轉換至一個新的狀態,并根據狀態的變化給出上一動作的獎勵值,其控制框架如圖1所示。深度強化學習的交通信號控制模型的關鍵問題是如何設置智能體,即獎勵、狀態和行動的定義[16]。

圖1 深度強化學習控制框架

2.3.1 狀態

智能體根據定量表示的環境狀態決定采取的動作。常用狀態可表示為描述環境的各種元素,如隊列長度、等待時間、速度和相位等。這些元素可以在車道或路段上定義,進而連接為一個向量。在早期使用強化學習進行交通信號控制的工作中,人們需要離散狀態空間,并使用一個簡單的表格或線性模型來近似狀態函數以提高效率[17]。然而,現實世界的狀態空間通常都很大,這在內存或性能方面限制了傳統的強化學習方法。

隨著深度學習的發展,深度強化學習方法被提出來作為一種有效的函數逼近器處理大的狀態空間。Xu[18]等人和Zhang[19]等人將交叉口分割為固定長度的網格,通過每個網格中的布爾值確定該位置是否存在車輛,這種網絡化的表示形式實現了交通狀態編碼的離散化,可以獲得高分辨率的真實交叉口信息。一類廣泛使用的狀態定義方法將交叉口各個車道的特定信息的平均值或總值作為特征組成一個狀態向量,例如車輛等待時間、排隊長度及信號燈相位持續時間等[20,21]。另一類使用圖像來表示狀態[22,23],其中車輛的位置被提取為圖像表示。

2.3.2 動作

智能體在獲得當前環境狀態后,從動作集中選擇要采取的動作并觀察動作帶來的獎勵及新的環境狀態。對交通信號控制的智能體有不同類型的動作定義:(1)設置當前相位持續時間[24];(2)設置當前相位持續時間與預定義的相位總周期持續時間的比率[25];(3)在預定義的信號配時方案中,由當前相位更改到下一相位,不改變相序[26];(4)在預定義的相位中選擇需要更改的相位[27]。動作的選擇與交通信號的具體設置密切相關。例如,如果要求相位序列是循環的,那么應該考慮前三種作用方案,而在預定義的相位中選擇需要更改的相位可以產生靈活的相位序列。

2.3.3 獎勵

獎勵反應深度強化學習智能體的學習目標,在交通信號控制中,考慮設置等待時間[28,29]、累計延誤[30]及車輛排隊長度[31]等。單一的獎勵難以全面反映環境反饋,因此一些學者考慮排隊長度、等待時間等數據的權衡系數[21]。然而獎勵中每個因素的權重是難以設定的,而權重設置的微小差異可能會導致顯著不同的結果[32]。在面對多交叉口交通信號控制問題時,通常會設置全局獎勵和局部獎勵,局部獎勵反映每個交叉口的交通狀況,提高每個智能體的穩定性;而全局獎勵使得智能體協作以學習整個路網的最優策略。在智能體的學習過程中,首先通過局部獎勵關注局部任務,然后利用學習到的局部信息優化全局策略[33]。

3 基于深度強化學習的單交叉口信號控制優化

近年來,基于深度強化學習的交通信號控制受到了研究者的廣泛關注,由于其處理狀態空間的能力,已經提出了許多深度強化學習模型進行信號控制。

利用深度神經網絡近似Q函數[34],Gendes等人[35]結合深度強化學習與交通信號控制,使用離散的交通狀態編碼模型,利用獲取的交通環境信息來形成類似圖像的狀態表示。Gendes等人[36]使用A3C算法研究了不同狀態表示對信號控制優化的影響,并利用動態交通環境在單個十字路口上實驗了三個獨立的狀態定義。其后,該作者研究了交通信號控制的異步深度強化學習模型,一般網絡的全局參數在每隔n步后更新一次。與固定時間和驅動的交通控制器相比,提出的體系結構的性能提高了近40%。Garg等人[37]提出了一種基于策略梯度的深度RL方法的自適應交通交叉口控制,該方法利用原始像素作為基于策略的DQN的輸入狀態。

Nishi等人[38]提出了一種基于自動編碼器的深度強化學習算法,通過將輸入隊列長度映射到低維動作集,考慮自動編碼器進行動作選擇。Gao等人[39]提出了一種新的神經網絡結構,神經網絡的輸出是二進制動作,無論是保持相同的動作還是在一個預定義的相位周期中改變動作。Choe等人[40]在單交叉口信號控制場景中提出了一個基于RNN的DQN模型,與CNN結構相比該方法明顯降低了旅行時間。Wan等人[41]提出了一種基于新的折扣因子的動作值的DQN,他們所提出的動態折扣因子借助于無限幾何級數,考慮了執行時間。Xu等人[42]引入了一種新的具有批處理學習框架的遷移學習模型,利用相同的真實數據和一個合成的模擬數據在一個孤立的交叉口上進行實驗。Jang等人[43]通過java的AnyLogic多用途模擬器將DQN智能體與流量模擬器集成。

4 基于深度強化學習的多交叉口信號控制優化

4.1 基于博弈論的多智能體深度強化學習方法

博弈論是研究理性決策者之間策略交互的數學模型,是解決城市交通信號協調控制問題的合適方法,使控制策略能較好地適應交通需求水平的動態變化[44,45]。近年來,結合博弈論的交通信號協調控制方法受到越來越多研究學者的重視。博弈論中的Nash均衡為路網中多個交叉口信號燈間的協調提供了理論框架,但仍面臨著由于維度爆炸而難以向更多交叉口擴展的難題,且各交叉口存在重要程度的差異性,使得在交通優化過程中,次要交叉口會為重要交叉口犧牲通行能力,導致目標沖突問題[46]。

目前,博弈論在交通領域中的應用大多集中在交通誘導和交通管理方面,而在交通信號配時決策中,博弈思想的應用還處于起步階段[47]。Clempner等人[48]將多交叉口信號控制問題表述為Stackelberg博弈過程,基于超近距離方法采用納什均衡求解。Zhao等人[49]提出了一種基于協調博弈和Pareto最優的算法,仿真結果表明,該算法在平均排隊長度、平均總延誤和平均旅行時間方面比韋伯斯特配時法和驅動控制算法更有效。Zhu等人[50]提出了一種基于行程數據的雙層博弈方法來解決路網交通控制問題。多智能體系統的自學習、交互式等特點與城市路網的多交叉口結構上的相似性,引起了眾多學者對多智能體系統及其自發學習機制在城市交通信號配時決策中應用的關注[51]。在路網環境下,由于系統中對任一交叉口信號燈的控制可能將延誤傳導至上下游以及其他交叉口[50],在此環境中的信號燈智能體的行為對環境的改變也會影響到其他智能體[52]。因此,與均衡相關的混合型博弈MARL算法[53]適用于路網信號控制問題。

近年來,許多研究者通過將MARL與博弈論相結合,使用博弈中的均衡解代替最優解,以求得相對有效且合理的交通信號控制策略[54]。Abdoos等人[54]提出了一種雙模式智能體結構,通過獨立和協作的過程有效地控制交通擁塞問題。在協作模式中,利用博弈論來確定智能體之間的協作機制,動態控制多個交叉口的交通信號。Guo等人[55]將博弈論與強化學習(RL)中的Q學習算法進行結合,提出了面向單交叉口信號燈的半合作NashQ學習算法和半合作StackelbergQ學習算法。Pan等人[56]融入博弈論的混合策略Nash均衡概念,改進IA-MARL算法的決策過程,提出了考慮博弈的多智能體強化學習(G-MARL)框架。Zhang等人[57]提出了基于Nash均衡的多智能體深度強化學習算法。Camponogara[58]利用隨機博弈論和RL研究了兩個交叉口信號燈之間的協調問題。Abolghasem[59]采用模糊Q學習和博弈論的方法,智能體根據以往經驗和相鄰智能體的策略進行決策。

4.2 平均場多智能體深度強化學習方法

通過平均場相互作用來描述大量具有對稱相互作用且不可區分參與者的行為。每個智能體都被表示為網格中的一個節點,該節點只受其鄰居的平均效應的影響。多智能體相互作用被有效地轉換為兩個智能體間相互作用。根據代理所試圖實現的目標,可以分成平均場博弈(MFG)和平均場控制(MFC)兩種類型的平均場問題。

對于MFC,分析了大種群中合作博弈的最優解,Gu等人[60]提出了MFC與Q函數結合的IQ函數,通過將狀態-空間替換為概率分布空間來提升強化學習。Carmona等人[61]基于MFC突出一個通用的強化學習框架,在此基礎上實現了基于狀態-動作值函數的通用無模型算法。

MFG的目的是在非合作的多玩家博弈中尋找納什均衡,由Lasry等人[62]和Huang等人[63]提出,以模擬相互作用中大量相同代理之間的動態平衡,試圖克服多智能體博弈問題中納什均衡所出現的困難。這類系統包括許多應用程序的建模,如交通堵塞動態、群體系統、金融市場均衡、人群疏散、智能電網控制、網絡廣告拍賣、疫苗接種動態等。Yang等人[64]證明了特殊的MFG可簡化為馬爾可夫決策過程(MDP),實現了MFG和MDP的結合,從而拓寬MFG的范圍,并通過深度逆強化學習來推斷大型現實世界系統的MFG模型。Xin等人[65]定義了一個基于模擬器的Q學習算法以求解有限狀態和動作空間下的平均場博弈。Anahtarc等人[66]證明了正則化Q學習在有限狀態和動作空間下的收斂性。Fu等人[67]提出了線性函數逼近的平均場演員評論家算法,并證明該算法以線性速率收斂到納什均衡。

將平均場理論與MARL結合,Blume等人[68]將每個智能體只與一組有限的鄰居直接交互,任意兩個智能體間通過有限的直接交互鏈間接交互,在降低智能體間相互作用復雜性的同時,仍保留了任何一對智能體之間的全局相互作用。Stanley等人[69]采用平均場理論逼近成對智能體間的相互影響。Lasry等人[62]利用平均場論將多智能體環境中的相互作用近似為兩個智能體相互作用。Yang等人[70]采用平均場理論,將多智能體間的相互作用近似為單個主體與整個總體或相鄰主體的平均效應之間的相互作用,利用離散時間平均場博弈來理解個體行為的總體效應,并預測種群分布的時間演化。Hu等人[71]設置一個智能體數量接近無限大的多智能體系統,通過平均效應來近似其他智能體對單個智能體的影響,導出描述多智能體群體中Q值概率分布演變的Fokker-Planck方程。Subramanian等人[72]提出一種基于策略梯度的方法來實現平均場均衡。

深度神經網絡具有強大的泛化能力,已被廣泛應用于直接逼近策略或值函數。利用神經網絡作為函數逼近器,可以解決MARL中的非平穩問題。Yang等人[70]提出了MF-Q及MF-AC算法,分析得到了Nash均衡的一致性,并在高斯擠壓、伊辛模型和戰斗游戲的實驗中證明了算法學習效果。該方法降低相互作用復雜性的同時,仍保留了任何一對智能體之間的全局相互作用,解決了維度爆炸問題,降低了環境的非平穩性。

4.3 聯網自動車輛環境下的多智能體深度強化學習方法

傳感、通信、網絡和計算技術的快速發展引發了新興的概念,如聯網自動車輛(CAV)。在CAV的范式中,未來的車輛可以通過大量的車載設備有效地監測其內部健康狀況,以提高運輸安全。此外,車輛將變得更加智能,能夠完全自主駕駛,極大地改善了用戶體驗。DRL智能體通過與環交互,通過反復錯來學習正確的操作。這樣,基于深度強化學習的模型就不會受到人類行為的限制,從而產生一些超人的行為。

此外,CAV還可以通過與環境的交互來體驗數字交通條件。當采取不當行動時,它們可能會產生或遇到一些角落的場景,如碰撞和近碰撞。通過這種方式,它們將受到懲罰,從而學會避免危險或容易崩潰的行為。因此,學習到的基于深度強化學習的模型通常承諾具有魯棒性。深度強化學習已成功應用于許多CAV控制任務,如車道保持、車道改變、避障、合并和交叉。新興的CAV技術為城市信號交叉口管理提供了新的機會。通過無線通信和先進的傳感能力,CAV可以檢測周圍的交通環境,與基礎設施實時共享車輛信息,可以精確控制CAV的各個軌跡。

之前的一些研究已經將CAV數據納入交通信號控制,并檢查了由此產生的好處[73]。Lee等人[74]開發了一種在100%CAV市場滲透率(MPR)下的累積旅行時間響應式實時交叉口控制算法,其中總延遲可減少34%。Guler等人[75]整合了來自簡歷和檢測器的信息,優化了雙向交叉口的放電序列,在平衡交通需求的情況下,減少了55%的平均延遲。Feng等人[76]提出了一個利用CAV軌跡信息來支持交通信號優化的雙層優化框架,并采用動態規劃(DP)來解決該問題。他們還提出了一種估計未裝備車輛的速度和位置的算法。結果表明,在100%PR下,不同目標函數下的平均延遲可以從6.37%降低到16.33%。Li和Ban[77]還提出了一種兩階段信號優化方法,它可以很容易地擴展到多個信號的協調。

另一個研究方向是根據實時信號相位和定時(SPaT)和交通條件完全控制CAV軌跡[78,79]。我們開發了一些基于CAV的模型/算法來控制個體車輛軌跡[80-82],其中CAV可以根據給定的SPaT調整其軌跡。一些研究采用傳統方法獲取最優軌跡,如模型預測控制[83,84]、DP[85,86]和近似模型[87,88]。然而,這些模型/算法中的大多數都是計算密集型的。因此,提出了具有給定邊界的分析方法,以減少計算負擔[89,90]。Zhoou等人[91]提出了一種簡約的啟發式算法,該算法通過控制詳細的加速度剖面,可以有效地平滑接近信號交叉口的車輛流的所有軌跡。該算法用幾段解析二次曲線來表示每一個無限維的車輛軌跡。因此,它有效地構建了大量的車輛軌跡,受物理限制、車輛跟蹤安全和交通信號定時。

最近,研究者關注了信號優化和車輛軌跡控制的集成框架——這是繼簡歷和汽車文獻之后自然的下一步。然而,據我們所知關于這一主題的研究數量仍然有限。Li等人[92]早期研究信號和車輛軌跡的聯合控制,使用簡單的運動學構建車輛軌跡,同時純粹列舉最優信號規劃。Pourmehrab等人[93]繼續這項研究,用綠色時間延長取代了純計數,沒有考慮車輛和信號定時控制之間的復雜相互作用。Feng等人[94]提出了一個時空交通控制框架來優化交通信號和車輛軌跡。Yu等人[95]聯合優化了100%CAV場景下的交通信號和車輛軌跡,其中考慮了所有車輛的運動,包括左轉、右轉彎和通過交通。索利曼亞米里等人[96]提出了一種使用簡化近似函數的解析聯合優化方法,結果顯示在兩相交叉處有顯著的改進。

5 總結與展望

本文針對深度強化學習在交通信號控制中的應用進行了總結,許多研究到目前為止獲得了卓越的研究成果,但仍存在許多重大挑戰和亟待解決的技術問題。下面對未來的研究方向進行探討。

5.1 協調

在多交叉口信號控制中需要協調智能體使其共識達成一致,特別是,在合作環境中實現共同目標需要連貫的動作選擇,以便聯合動作實現共同優化目標。在決策過程中找到共識可以通過智能體之間的信息交換實現,也可以通過構建模型實現。前者需要智能體通信機制,以便智能體可在各自目標的基礎上進行協調。對于后者,智能體需要能夠觀察其他智能體的動作并推理其策略以構建模型。在預測模型基礎上,智能體可以學習其他智能體的動作模式,并將動作應用到共識中從而實現協調。

5.2 可計算性

對大量智能體進行訓練的難度非常大,環境中的每個智能體都會給學習過程增加額外的復雜性,從而使計算量因智能體數量呈指數級增長。除了復雜性問題之外,眾多可變因素也使得智能體需要對其他智能體的行為具有魯棒性。但是,智能體可以利用智能體之間共享的分布式知識來加速學習過程。

5.3 安全性

未來研究工作還集中在安全性方面,安全性是非常重要的屬性,因為自主智能體要確保交通系統性能,同時還要在學習和執行動作期間確保安全。單智能體學習算法研究中涉及了安全概念,但其對多智能體學習的適用性有限,仍處于起步階段。

綜上所述,基于深度強化學習的多交叉口信號控制優化是研究領域現階段研究的難點與重點之一,每個智能體都有一個需要優化的本地目標,然而,只有當智能體允許其他智能體能成功完成其任務時,才能實現全局最優。另一個可能方向是深度多智能體強化學習算法和進化方法之間的融合。進化算法已被用于多智能體強化學習的環境中,由于進化需要許多實體進行適應,因此多智能體強化學習場景非常適合進化計算。

現階段大多數研究都集中在同質環境中的學習,在這些環境中智能體具有共同的興趣并優化共同的目標。當智能體具有共同利益時,諸如非平穩性、部分可觀察性和協調性之類的問題可能會減少。然而,異質性意味著智能體可能有自己的興趣和目標,個人經驗和知識,或者不同的技能和能力。在真實應用場景中,智能體需要利用異構信息做出決策。

隨著交叉口數量的增加,基于深度強化學習的交通信號控制優化領域最根本問題是維度災難,“狀態-動作”空間和智能體相互作用的組合隨著智能體數量呈指數級增長,這使得完全遍歷空間難以實現。且當智能體只能獲得對環境的部分觀察或當環境具有連續性質時,這種情況會加劇。盡管深度神經網絡作為函數近似器可以應對連續空間,并且可以很好地降低計算量,但仍然存在一些問題,比如如何充分探索大型和復雜路網,以及如何解決區域交通信號優化問題等。

作者簡介:

張尊棟(1979-),男,講師,博士,現任教于北方工業大學,研究方向為智能交通。

劉雨珂(1999-),女,碩士,現就讀于北方工業大學,研究方向為智能交通。

劉小明(1974-),男,教授,博士,現任教于北方工業大學,研究方向為交通流理論、智能交通控制。

參考文獻:

[1] WEIH, ZHENG G, GAYAH V, et al. Recent advances in reinforcement learning for traffffic signal control: A survey of models and evaluation[J]. SIGKDD Explor. Newsl., 2021, 22 (2) : 12 - 18.

[2] MIKAMI S, KAKAZU Y. Genetic reinforcement learning for cooperative traffffic signal control[C]//Proceedings of the First IEEE Conference on Evolutionary Computation. IEEE World Congress on Computational Intelligence. [S.l.: s.n.], 1994 : 223 - 228 vol.1.

[3] MNIH V, KAVUKCUOGLU K, SILVER D, et al. Human-level control through deep reinforcement learning[J]. Nature, 2015, 518 : 529 - 533.

[4] LI L, LV Y, WANG F Y. Traffffic signal timing via deep reinforcement learning[J]. IEEE/CAA Journal of Automatica Sinica, 2016, 3 (3) : 247 - 254.

[5] WATKINS J, DAYAN P. Q-learning[J]. Machine Learning, 1992, 8 : 279 -292.

[6] MNIH V, KAVUKCUOGLU K, SILVER D, et al. Playing atari with deep reinforcement learning[J]. Computer Science, 2013.

[7] VAN HASSELT H, GUEZ A, SILVER D. Deep reinforcement learning with double q-learning[Z]. [S.l.: s.n.], 2016.

[8] WANG Z, SCHAUL T, HESSEL M, et al. Dueling network architectures for deep reinforcement learning[C]//ICML'16: Proceedings of the 33rd International Conference on International Conference on Machine Learning - Volume 48. [S.l.]: JMLR.org, 2016 : 1995 - 2003.

[9] NAIR A, SRINIVASAN P, BLACKWELL S, et al. Massively parallel methods for deep reinforcement learning[J]. Computer Science, 2015.

[10] WILLIAMS R J. Simple statistical gradient-following algorithms for connectionist reinforcement learning[J]. Machine Learning, 1992, 8 (3- 4) : 229 - 256.

[11] SCHULMAN J, LEVINE S, ABBEEL P, et al. Trust region policy optimization[C]//Proceedings of Machine Learning Research: volume 37 Proceedings of the 32nd International Conference on Machine Learning. [S.l.]: PMLR, 2015 : 1889 - 1897.

[12] SCHULMAN J, WOLSKI F, DHARIWAL P, et al. Proximal policy optimization algorithms[J]. Advances in Neural Information Processing Systems, 2017.

[13] LILLICRAP T, HUNT J, PRITZEL A, et al. Continuous control with deep reinforcement learning[J]. CoRR, 2015 : 09.

[14] FUJIMOTO S, VAN HOOF H, MEGER D. Addressing function approximation error in actorcritic methods[J]. ArXiv, 2018, abs/1802.09477.

[15] LIU B, CAI Q, YANG Z, et al. Neural proximal/trust region policy optimization attains globally optimal policy[M]. [S.l.]: Curran Associates Inc., 2019.

[16] YAU K L A, QADIR J, KHOO H L, et al. A survey on reinforcement learning models and algorithms for traffffic signal control[J]. ACM Comput. Surv., 2017, 50 (3) .

[17] ABDOOS M, MOZAYANI N, BAZZAN A L C. Hierarchical control of traffffic signals using q-learning with tile coding[J]. Applied Intelligence, 2013, 40 : 201 - 213.

[18] XU M, WU J, HUANG L, et al. Network-wide traffffic signal control based on the discovery of critical nodes and deep reinforcement learning[J]. Journal of Intelligent Transportation Systems, 2020, 24 (1) : 1 - 10.

[19] ZHANG R, ISHIKAWA A, WANG W, et al. Using reinforcement learning with partial vehicle detection for intelligent traffffic signal control[J/OL]. IEEE Transactions on Intelligent Transportation Systems, 2021, 22 (1) : 404 - 415.

[20] CHU T, WANG J, CODECà L, et al. Multi-Agent Deep Reinforcement Learning for Large-Scale Traffffic Signal Control[J/OL]. IEEE Transactions on Intelligent Transportation Systems, 2020, 21 (3) : 1086 - 1095.

[21] XIE D, WANG Z, CHEN C, et al. Iedqn: Information exchange dqn with a centralized coordinator for traffffic signal control[C/OL]//2020 International Joint Conference on Neural Networks (IJCNN) . 2020 : 1 - 8.

[22] LIANG X, DU X, WANG G, et al. A deep reinforcement learning network for traffffic light cycle control[J/OL]. IEEE Transactions on Vehicular Technology, 2019, 68 (2) : 1243 - 1253.

[23] GONG Y, ABDEL-ATY M, CAI Q, et al. Decentralized network level adaptive signal control by multi-agent deep reinforcement learning[J/OL]. Transportation Research Interdisciplinary Perspectives, 1 : 100020.

[24] ASLANI M, SEIPEL S, MESGARI M S, et al. Traffffic signal optimization through discrete and continuous reinforcement learning with robustness analysis in downtown tehran[J/OL]. Advanced Engineering Informatics, 2018, 38 : 639-655. https://www.sciencedirect.com/scienc e/article/pii/S1474034617302598.

[25] MA Z, CUI T, DENG W, et al. Adaptive optimization of traffffic signal timing via deep reinforcement learning[J/OL]. Journal of Advanced Transportation, 2021, 2021 : 1 - 14.

[26] ZHU Y, CAI M, SCHWARZ C, et al. Intelligent traffffic light via policy- based deep reinforcement learning[J]. International Journal of Intelligent Transportation Systems Research, 2021, 20 : 734 - 744.

[27] SUN Y, LAI J, CAO L, et al. A Friend-or-Foe framework for multi-agent reinforcement learning policy generation in mixing cooperative– competitive scenarios[J]. Transactions of the Institute of Measurement and Control, 2022, 44 : 2378 - 2395.

[28] LI D, WU J, XU M, et al. Adaptive traffffic signal control model on intersections based on deep reinforcement learning[J]. Journal of Ad vanced Transportation, 2020, 2020 : 1 - 14.

[29] SHABESTARY S M A, ABDULHAI B. Adaptive traffffic signal control with deep reinforcement learning and high dimensional sensory inputs: Case study and comprehensive sensitivity analyses[J]. IEEE Transactions on Intelligent Transportation Systems, 2022, 23 : 20021 - 20035.

[30] GUILLEN-PEREZ A, CANO M D. Intelligent iot systems for traffffic management: A practical application[J]. IET Intelligent Transport Systems, 2021.

[31] WU T, ZHOU P, LIU K, et al. Multi-agentdeep reinforcement learning for urban traffffic light control in vehicular networks[J]. IEEE Transactions on Vehicular Technology, 2020, 69 : 8243 - 8256.

[32] BOUKERCHE A F M, ZHONG D, SUN P. A novel reinforcement learning-based cooperative traffffic signal system through max pressure control[J]. IEEE Transactions on Vehicular Technology, 2021, 71 : 1187 - 1198.

[33] SAKIB S M N, TAZRIN T, FOUDA M M, et al. An efffficient and lightweight predictive channel assignment scheme for multiband b5g- enabled massive iot: A deep learning approach[J]. IEEE Internet of Things Journal, 2021, 8 : 5285 - 5297.

[34] AREL I, LIU C, URBANIK T, et al. Reinforcement learning-based multi- agentsystem for network traffffic signal control[J]. Iet Intelligent Transport Systems, 2010, 4 : 128 - 135.

[35] GENDERS W, RAZAVI S N. Using a deep reinforcement learning agent for traffffic signal control[J]. ArXiv, 2016, abs/1611.01142.

[36] GENDERS W, RAZAVI S. Evaluating reinforcement learning state representations for adaptive traffffic signal control[J]. Procedia Computer Science, 2018, 130 : 26 - 33.

[37] GARG D, CHLI M, VOGIATZIS G. Deep reinforcement learning for autonomous traffffic light control[C/OL]//2018 3rd IEEE International Conference on Intelligent Transportation Engineering (ICITE) . 2018 : 214 - 218.

[38] NISHI T, OTAKI K, HAYAKAWA K, et al. Traffffic signal control based on reinforcement learning with graph convolutional neural nets[C/OL]//2018 21st International Conference on Intelligent Transportation Systems (ITSC) . 2018 : 877 - 883.

[39] GAO J, SHEN Y, LIU J, et al. Adaptive traffffic signal control: Deep reinforcement learning algorithm with experience replay and target network[J]. ArXiv, 2017, abs/1705.02755.

[40] CHOE C J, BAEK S, WOON B, et al. Deep q learning with lstm for traffffic light control[C/OL]//2018 24th Asia-Pacific Conference on Communications (APCC) . 2018 : 331 - 336.

[41] WAN C H, HWANG M C. Value-based deep reinforcement learning for adaptive isolated intersection signal control[J/OL]. IET Intelligent Transport Systems, 2018, 12 : 1005 - 1010.

[42] XU N, ZHENG G, XU K, et al. Targeted knowledge transfer for learning traffffic signal plans[C]//Pacific-Asia Conference on Knowledge Discovery and Data Mining. [S.l.: s.n.], 2019.

[43] JANG I, KIM D, LEE D, et al . An agent -based simulation model ing with deep reinforcement learning for smart traffffic signal control[C/OL]//2018 International Conference on Information and Com munication Technology Convergence (ICTC) . 2018 : 1028 - 1030.

[44] Nam Bui K H, JUNG J J. Cooperative game-theoretic approach to traffffic flow optimization for multiple intersections[J].Computers and Electrical Engineering, 2018, 71 : 1012 - 1024.

[45] ARAGON-GóMEZ R, CLEMPNER J B. Traffffic-signal control reinforcement learning approach for continuous-time markov games[J]. Engineering Applications of Artificial Intelligence, 2020, 89 : 103415.

[46] RUI T, CHAI L, SHANGGUAN W, et al. Multi mode travel recom mendation method for passengers at hub airport under the

constraint of public transport timetable[C]//2021 China Automation Congress (CAC) . [S.l.: s.n.], 2021 : 6106 - 6112.

[47] KYAMAKYA K, CHEDJOU J C, AL-MACHOT F, et al. Intelligent transportation related complex systems and sensors[J]. Sensors, 2021, 21 (6) .

[48] CLEMPNER J B, POZNYAK A S. Modeling the multi-traffffic signal- control synchronization: A markov chains game theory approach[J]. Engineering Applications of Artificial Intelligence, 2015, 43 : 147 - 156.

[49] ZHAO Y, LIANG Y, HU J, et al. Traffffic signal control for isolated intersection based on coordination game and pareto efffficiency[C]//2019 IEEE Intelligent Transportation Systems Conference (ITSC) . [S.l.: s.n.], 2019 : 3508 - 3513.

[50] ZHU Y, HE Z, LI G. A bi-hierarchical game-theoretic approach for network-wide traffffic signal control using trip-based data[J/OL]. IEEE Transactions on Intelligent Transportation Systems, 2022, 23 (9) : 15408 - 15419.

[51] CHEN C, WEI H, XU N, et al. Toward a thousand lights: Decentralized deep reinforcement learning for large-scale traffffic signal control[C]// AAAI 2020 - 34th AAAI Conference on Artificial Intelligence: AAAI 2020 - 34th AAAI Conference on Artificial Intelligence.

[S.l.]: AAAI press, 2020 : 3414 - 3421.

[52] BU ONIU L, BABU? KA R, DE SCHUTTER B. Multi- Agent Reinforcement Learning: An Overview[M]. Berlin, Heidelberg: Springer Berlin Heidelberg, 2010 : 183 - 221.

[53] GRONAUER S, DIEPOLD K. Multi-agent deep reinforcement learning: a survey[J]. Artificial Intelligence Review, 2021, 55 : 895 - 943.

[54] ABDOOS M. A Cooperative Multi agent system for traffffic signal control using game theory and reinforcement learning[J/OL].IEEE Intelligent Transportation Systems Magazine, 2021, 13 (4) : 6 - 16.

[55] GUO J, HARMATI I. Evaluating semi-cooperative nash/stackelberg q-learning for traffffic routes plan in a single intersection[J]. Control Engineering Practice, 2020, 102 : 104525.

[56] PAN Z, QU Z, CHEN Y, et al. A distributed assignment method for dy namic traffffic assignment using heterogeneous-adviser based multi-agent reinforcement learning[J/OL]. IEEE Access, 2020, 8 : 154237 - 154255.

[57] ZHANG Z, QIAN J, FANG C, et al . Coordinated control of distributed traffffic signal based on multi agent cooperative game[J/OL]. Wireless communications and mobile computing, 2021, 2021 : 1 - 13.

[58] CAMPONOGARA E, KRAUS W. Distributed learning agents in urban traffffic control[C]//PIRES F M, ABREU S. Progress in Artifi-cial Intelligence. Berlin, Heidelberg: Springer Berlin Heidelberg, 2003 : 324 - 335.

[59] DAEICHIAN A, HAGHANI A. Fuzzy q-learning-based multi-agent system for intelligent traffffic control by a game theory approach[J]. Arabian journal for science and engineering, 2018, 43 : 3241 - 3247.

[60] GU H, GUO X, WEI X, et al. Dynamic programming principles for meanfield controls with learning[J]. arXiv, 2019.

[61] CARMONA R, LAURIèRE M, TAN Z. Model-free mean-field re inforcement learning: Mean-field mdp and mean-field q-learning[J]. arXiv, 2019.

[62] LASRY J M, LIONS P L. Mean field games[J]. Japanese journal of mathematics, 2007, 2 (1) : 229 - 260.

[63] HUANG M, MALHAME R, CAINES P. Large population stochastic dynamic games: Closed-loop mckean-vlasov systems and the nash certainty equivalence principle[J]. Commun. Inf. Syst., 2006, 6.

[64] YANG J, YE X, TRIVEDI R, et al. Deep mean field games for learning optimal behavior policy of large populations[C]// International confer ence on learning representations. [S.l.: s.n.], 2018.

[65] GUO X, HU A, XU R, et al. Learning mean-field games[J]. In Advances in Neural Information Processing Systems, 2019: 4966-4976.

[66] ANAHTARCL B, KARIKSIZ C, SALDI N. Q-learning in regularized mean-field games[J]. arXiv, 2020.

[67] FU Z, YANG Z, CHEN Y, et al. Actorcritic provably finds nash equilibria of linear-quadratic mean-field games[J]. CoRR, 2019,abs/1910.07498.

[68] BLUME L E. The statistical mechanics of strategic interaction[J]. Games and Economic Behavior, 1993, 5 (3) : 387 - 424.

[69] STANLEY H. Phase transitions and critical phenomena[M]. [S.l.]: Oxford University Press, 1971.

[70] YANG Y, LUO R, LI M, et al. Mean Field Multi-Agent Reinforcement Learning[C]//Proceedings of Machine Learning Research: vol.80 Proceedings of the 35th International Conference on Machine Learning. 2018 : 5571 - 5580.

[71] HU S, LEUNG C W, LEUNG H F. Modelling the dynamics of multi agent q-learning in repeated symmetric games: A Mean Field The oretic Approach[M]. Curran Associates Inc., 2019.

[72] SUBRAMANIAN J, MAHAJAN A. Reinforcement learning in stationary mean-field games[C]//AAMAS '19: Proceedings of the 18th International Conference on Autonomous Agent s and Multi AgentSystems. [S.l.]: International Foundation for Autonomous Agent s and Multi Agent Systems, 2019 : 251 - 259.

[73] YANG K, GULER S, MENENDEZ M. Isolated intersection control for various levels of vehicle technology: Conventional, connected, and automated vehicles[J/OL]. Transportation Research Part C: Emerging Technologies, 2016, 72 : 109 - 129.

[74] LEE J, PARK B B, YUN I. Cumulative travel-time responsive real-time intersection control algorithm in the connected vehicle environment[J]. Journal of Transportation Engineering-asce, 2013, 139 : 1020 - 1029.

[75] GULER S I, MENéNDEZ M, MEIER L. Using connected vehicle technology to improve the efffficiency of intersections[J].Transportation Research Part C: emerging Technologies, 2014, 46 : 121 - 131.

[76] FENG Y, HEAD K L, KHOSHMAGHAM S, et al. A real-time adaptive signal control in a connected vehicle environment[J/OL]. Transportation Research Part C: Emerging Technologies, 2015, 55 : 460 - 473.

[77] LI W, BAN X. Connected vehicles based traffffic signal timing optimization[J/OL]. IEEE Transactions on Intelligent Transportation Systems, 2019, 20 (12) : 4354 - 4366.

[78] XU B, BAN X J, BIAN Y, et al. Cooperative method of traffffic signal optimization and speed control of connected vehicles at isolated intersections[J/OL]. IEEE Transactions on Intelligent Transportation Systems, 2019, 20 (4) : 1390 -1403.

[79] GUO Q, LI L, (Jeff) Ban X. Urban traffffic signal control with connected and automated vehicles: A survey[J/OL]. Transportation Research Part C: Emerging Technologies, 2019, 101 : 313 - 334.

[80] AHN K, RAKHA H A, PARK S. Ecodrive application: Algorithmic development and preliminary testing[J/OL]. Transportation Research Record, 2013, 2341 (1) : 1 - 11.

[81] WANG M, DAAMEN W, HOOGENDOORN S P, et al. Rolling horizon control framework for driver assistance systems. part i: Mathematical formulation and non-cooperative systems[J/OL]. Transportation Research Part C: Emerging Technologies, 2014, 40 : 271 - 289.

[82] WANG M, DAAMEN W, HOOGENDOORN S P, et al. Rolling horizon control framework for driver assistance systems. part ii: Cooperative sensing and cooperative control[J/OL]. Transportation Research Part C: Emerging Technologies, 2014, 40 : 290 - 311.

[83] ASADI B, VAHIDI A. Predictive cruise control: Utilizing upcoming traffffic signal information for improving fuel economy and reducing trip time[J/OL]. IEEE Transactions on Control Systems Technology, 2011, 19 (3) : 707 - 714.

[84] KAMAL M A S, MUKAI M, MURATA J, et al. Model predictive control of vehicles on urban roads for improved fuel economy[J/OL]. IEEE Transactions on Control Systems Technology, 2013, 21 (3) : 831 - 841.

[85] MAHLER G, VAHIDI A. An optimal velocity-planning scheme for vehicle energy efffficiency through probabilistic prediction of traffffic-signal timing[J/OL]. IEEE Transactions on Intelligent Transportation Sys- tems, 2014, 15 (6) : 2516 - 2523.

[86] OZATAY E, ONORI S, WOLLAEGER J, et al. Cloud-based velocity profile optimization for everyday driving: A dynamic programming- based solution[J/OL]. IEEE Transactions on Intelligent Transportation Systems, 2014, 15 (6) : 2491 - 2505.

[87] HE X, LIU H X, LIU X. Optimal vehicle speed trajectory on a signalized arterial with consideration of queue[J/OL]. Transportation Research Part C: Emerging Technologies, 2015, 61 : 106 - 120.

[88] WU X, HE X, YU G, et al. Energy-optimal speed control for electric vehicles on signalized arterials[J/OL]. IEEE Transactions on Intelligent Transportation Systems, 2015, 16 (5) : 2786 - 2796.

[89] OZATAY E, OZGUNER U, ONORI S, et al. Dynamic systems and control conference: Volume 1: Adaptive control; advanced vehicle propulsion systems; aerospace systems; autonomous systems; battery modeling; biochemical systems; control over networks; control systems design; cooperative and decentralized control; dynamic system modeling; dynamical modeling and diagnostics in biomedical systems; dynamics and control in medicine and biology; estimation and fault detection; estimation and fault detection for vehicle applications; fluid power systems; human assistive systems and wearable robots; human-in-the-loop systems; intelligent transportation systems; learning control analytical solution to the minimum fuel consumption optimization problem with the existence of a traffffic light[C]. [S.l.: s.n.], 2012 : 837 - 846.

[90] WAN N, VAHIDI A, LUCKOW A. Optimal speed advisory for con- nected vehicles in arterial roads and the impact on mixed traffffic[J]. Transportation Research Part C: Emerging Technologies, 2016, 69 : 548 - 563.

[91] ZHOU F, LI X P, MA J Q. Parsimonious shooting heuristic for trajectory design of connected automated traffic part I: Theoretical analysis with generalized time geography[J].Transportation Research Part B: Methodological, 2017, 95 : 394 - 420.

[92] LI Z, ELEFTERIADOU L, RANKA S. Signal control optimization for automated vehicles at isolated signalized intersections[J].Transporta- tion Research Part C: Emerging Technologies, 2014, 49 : 1 - 18.

[93] POURMEHRAB M, ELEFTERIADOU L, RANKA S, et al. Optimizing signalized intersections performance under conventional and automated vehicles traffffic[J/OL]. IEEE Transactions on Intelligent Transportation Systems, 2020, 21 (7) : 2864 - 2873.

[94] FENG Y, YU C, LIU H X. Spatiotemporal intersection control in a connected and automated vehicle environment[J/OL]. Transportation Research Part C: Emerging Technologies, 2018, 89 : 364 - 383.

[95] YU C, FENG Y, LIU H X, et al. Integrated optimization of traffffic signals and vehicle trajectories at isolated urban intersections[J/OL]. Transportation Research Part B: Methodological, 2018, 112 : 89 - 112.

[96] SOLEIMANIAMIRI S, GHIASI A, LI X, et al. An analytical optimization approach to the joint trajectory and signal optimization problem for connected automated vehicles[J/OL]. Transportation Research Part C: Emerging Technologies, 2020, 120 : 102759.

摘自《自動化博覽》2022年12月刊